Bildbearbeitung mit Hirn

Künstliche Intelligenz macht Bildbearbeitung intuitiv

Künstliche neuronale Netze beschreiben Fotos, übersetzen Texte und lernen Strategiespiele auf Weltklasse-Niveau – aber das war erst der Anfang. Neuere Netzarchitekturen generieren bereits fotorealistische Bilder. Sie schicken sich an, die Fotoretusche zu revolutionieren und sollen Computern auf längere Sicht die Welt als Ganzes erklären.

Menschen wissen intuitiv, wie ein gutes, realistisches Foto auszusehen hat. Selbst Laien stören sich an blaustichigen Winterbildern und Magenta-schimmernden Hauttönen. Und dass der wöchentliche Gartenmarktprospekt hastig vom Praktikanten zusammengeschustert wurde, verraten üppig tragende Bäume, deren Früchte zu schweben scheinen.

Das Erkennen fällt leicht, das Verbessern ungleich schwerer, denn Bildbearbeitungsprogramme denken nicht in Szenen und Objekten, sondern in Tonwerten, Histogrammen und Filtern. Und ihr Werkzeugsortiment ist oft so mächtig, dass es Laien überfordert, oder so einfach, dass es kreative Ideen nicht unterstützt. Klassische Autokorrektur wird den vielen Facetten der Fotografie nicht gerecht, Ein-Klick-Effekte langweilen auf Dauer.

Doch das ändert sich gerade fundamental. An Universitäten und in den Forschungsabteilungen von Konzernen wie Adobe, Google, Facebook und Co. entstehen faszinierende Techniken, die intuitive, direkte Bildbearbeitung ermöglichen. Sie alle wurden auf Basis tiefer neuronaler Netze entwickelt (Deep Learning) – jener Konstrukte, die Google vor fünf Jahren erfolgreich auf die Erkennung von Katzen trainiert hatte, was das Thema Künstliche Intelligenz über Nacht zur Zukunftstechnologie schlechthin beförderte.

Tiefe Netze bestehen aus mehreren Schichten von Neuronen, die über Synapsen miteinander verknüpft sind. Netzarchitektur und -funktionsweise sind dem visuellen Cortex des Menschen nachempfunden, der die in Bildern enthaltenen Informationen zerlegt, abstrahiert und an die nächste Verarbeitungsstufe weiterleitet – wodurch sie nach und nach zu immer komplexeren Merkmalen zusammengesetzt werden. Ähnlich wie der Mensch erlernen die künstlichen Netze ihre Fähigkeiten, Objekte zu erkennen, allein indem sie zahllose Bildbeispiele betrachten – und über eine Fehlerfunktion Feedback dazu erhalten, ob sie mit ihrer Einschätzung richtig liegen.

Verstehen heißt Erschaffen

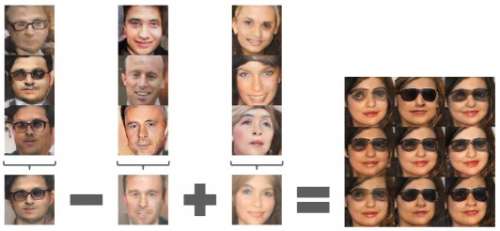

In den vergangenen Jahren sind die Netzarchitekturen deutlich komplexer geworden, unterschiedliche Disziplinen wie Spracherkennung, Spieltheorie und Bildverarbeitung bereichern sich gegenseitig. Vor zwei Jahren gelang Ian Goodfellow, damals Doktorand an der Universität von Montreal, ein gänzlich revolutionärer Ansatz, den Facebooks KI-Direktor Yann LeCun die „auf dem Feld des Maschinellen Lernens wichtigste Idee der letzten zehn Jahre“ nannte: Generative Adversarial Networks (GAN). Sie bestehen aus zwei konkurrierenden Netzen, die so miteinander verschaltet sind, dass beide durch den Wettstreit ihre Fähigkeiten perfektionieren. Um Bilder zu generieren, fungiert ein Netz als Fälscher und das andere als Detektiv, der die Fälschung erkennen soll.

Mit diesen neuartigen Netzen gelang es erstmals, fotorealistische Bilder zu produzieren anstatt sie nur zu interpretieren. Und: Anders als die bisher verwendeten Deep Learner benötigen GANs fürs Training keine vom Menschen klassifizierten Trainingsbeispiele. Für die Forscher ist dieses sogenannte unüberwachte Training das Ziel, auf das es in einer universellen KI hinauslaufen muss – und GANs sehen sie als Meilenstein auf dem Weg dorthin. Insbesondere die zahlreichen wissenschaftlichen Veröffentlichungen des vergangenen Jahres zu diesem Thema zeigen, welch enormes Potenzial generative Netze und ihre Varianten entfalten können. Intuitive, kontextsensitive Foto- und Videobearbeitung ist nur eine Anwendung unter vielen.

Eine mit allen Schikanen des maschinellen Lernens ausgestattete Bildbearbeitung könnte ihrem Nutzer umständliche Techniken mit Ebenen, Einstellungsebenen, Masken, Kanälen und Filtern ersparen und stattdessen auf simple (Sprach-)Befehle reagieren wie „Hänge Zitronen an den Baum“ oder „Personen aufhellen“. Ihre neuronal gesteuerte Autokorrektur verschiebt die Tonwerte nicht einfach nach einem festgelegten Schema. Stattdessen hat sie gelernt, Hochzeitsszenen anders zu optimieren als Action-Aufnahmen und eine atmosphärische Stimmung von einer Fehlbelichtung zu unterscheiden. Kurzum: Durch Maschinelles Lernen entstehen Editoren, die keine abstrakten Tonwerte verschieben, sondern ein tieferes Verständnis von Bildern, Fotos, Motiven und Kompositionen verinnerlicht haben – ähnlich wie ein Mensch.

Solche Techniken wünschen sich nicht nur Laien, sondern auch Profis, die unter Zeitdruck deutlich mehr Material abarbeiten müssen als noch vor 20 Jahren. Einige KI-Filter und -Apps kann man schon ausprobieren (siehe Artikel auf S. 86), andere stehen kurz vor der Marktreife, weitere sind visionär, aber noch sehr experimentell (siehe S. 80). Wer selbst in die Welt der tiefen Netze eintauchen möchte, kann mittlerweile aus diversen kostenlosen Frameworks wählen, etwa Caffe von Facebook oder TensorFlow von Google. Der Artikel auf Seite 90 zeigt, wie man mit TensorFlow ein Superresolution-Netzwerk trainiert.

Vom Analysten zum Kreativen

Doch wer bestimmt eigentlich, wie die Bildbearbeitung der Zukunft aussieht? Die KI-Konzerne Google und Facebook? Oder setzt sich am Ende doch wieder Adobe mit seiner langjährigen Erfahrung durch? Oder ein gänzlich Unbekannter aus der Start-up-Szene? Zumindest am Anfang war alles Google: Mit seiner Deep-Learning-Objekterkennung und perfekter Vermarktung katapultierte der Datenkonzern 2012 die schon mehrfach totgesagte Künstliche Intelligenz zur Technik der Zukunft, entwickelte sie weiter, zog KI-Forscher an wie ein Magnet, kaufte den Start-up-Markt förmlich leer und gründete eine eigene KI-Abteilung namens Google Brain. Als sich der Universal-Konzern dann noch das Photoshop-Entwickler-Urgestein John Nack ins Boot holte, der laut eigener Aussage gekommen war, um den Jungs dort mal beizubringen, wie Bildbearbeitung funktioniert, sah man die Felle der seit Jahrzehnten unangefochtenen Nummer eins – Adobe – schon davonschwimmen.

Besonders öffentlichkeitswirksam präsentierte Google vor zwei Jahren die psychedelisch wirkenden Kunstwerke, die es seinem auf Objekterkennung trainierten Deep Learner namens Inception entlockt hatte. Mit Kreativität – wie häufig unterstellt wurde – hatte all das aber nicht im Entferntesten zu tun. Denn die faszinierend-befremdlichen Netz-Werke waren lediglich Abfallprodukte von Visualisierungsmethoden, die beim Verstehen der Vorgänge in den tieferen Schichten der Netze helfen sollten.

Doch der Ehrgeiz war geweckt. Wenn neuronale Netze Surreales produzieren können, müsste es doch auch möglich sein, sie gezielt zur Kunst- oder gar Echtfoto-Produktion anzuregen. Ein erster Schritt in diese Richtung waren Apps wie Prisma und deepart.io, mit denen es plötzlich möglich war, ein Foto im Stil von Edvard Munchs „Der Schrei“ oder Picassos Guernica umzusetzen.

Vom Kreativen zum Realisten

Fotorealistische anstatt künstlerisch verfremdete Bilder künstlich zu produzieren ist allerdings eine harte Nuss, weil ein Foto-Generator, ein intelligentes Retuschewerkzeug oder ein Effektfilter keine beliebigen Korrekturen zulassen darf, sondern sich auf realistisch wirkende beschränken muss. Die Software muss also eine Vorstellung davon verinnerlicht haben, welche Farb- und Helligkeitsverläufe, Muster, Kanten et cetera in einer Fotografie stimmig wirken. Genau in dieser Disziplin haben Adobe-Forscher in den letzten Monaten auffällig vieles und Praxistaugliches präsentiert: fotorealistischer Stiltransfer, Autokorrektur, automatisches Freistellen – und Bildmanipulation mithilfe generativer Netzwerke. Erst vor wenigen Tagen hat Adobe aus diesen neuen Algorithmen eine Anwendung zur Porträt-Optimierung gestrickt und als Technik-Demo in Photoshop Touch gepackt.

Die Erfolge kommen nicht von ungefähr: Adobe entwickelt mit der Marketing Cloud seit Jahren Werkzeuge zum Sammeln, Auswerten und Visualisieren von Daten. Die Creative Cloud ermöglicht es dem Konzern, umfangreiche Nutzeranalysen durchzuführen, sofern der Kunde nicht widerspricht. Seit Herbst 2016 bündelt der Konzern seine KI-Forschung in einer eigenen Plattform namens Adobe Sensei – sie soll eines der größten strategischen Investments der nächsten Jahre werden (siehe Interview rechts).

Google scheint sich momentan vor allem auf KI-Techniken zu konzentrieren, die den wichtigsten Diensten des Konzerns unmittelbar nützen. Eine Schlüsseltechnik dafür ist das Superresolution-Netz RAISR, das Fotos selbst nach starker Vergrößerung knackscharf wirken lässt. RAISR hat anhand von Vergleichsbildern gelernt, die beim Skalieren auftretende Unschärfe zu kaschieren, indem es an passender Stelle sinnvolle Bilddetails ergänzt. Diese Technik wird bereits in Android eingesetzt, um Fotos unterwegs in bandbreiteschonender Auflösung zu übertragen. Auch Google Earth könnte dank RAISR die aus dem All aufgenommenen Landschaften scheinbar viel detaillierter zeigen als bisher.

Facebook setzt auf Augmented Reality; auf seiner Hausmesse F8 hat der Konzern gerade eine AR-Kamera-Plattform für Mobilgeräte vorgestellt. Eine ausgereifte Bildbearbeitungs-KI, die versteht, wie sich Objekte in ihrer natürlichen Umgebung verhalten, ist auch dafür der Schlüssel. (atr@ct.de)