Im Namen des Algorithmus

Wenn Software Haftstrafen verhängt

Bei Justiz und Polizei kommen immer häufiger Programme zum Einsatz, die Aussagen zur Wahrscheinlichkeit zukünftiger Straftaten treffen sollen. In den USA nehmen solche Vorhersage-Algorithmen bereits aktiven Einfluss auf Gerichtsurteile – mit zum Teil verheerenden Folgen für die Betroffenen. Und China verwandelt sich gleich ganz in eine totalitäre Datengesellschaft.

Den 12. August 2013 wird Eric Loomis nie vergessen. Denn an diesem schönen Sommertag im Mittleren Westen der USA verurteilte ein Gericht der Kleinstadt La Crosse im Bundesstaat Wisconsin den damals 31-Jährigen zu elf Jahren Gefängnis. Der Vorwurf: Führen eines Fahrzeugs ohne Einwilligung des Besitzers und versuchte Flucht vor der Polizei.

Mindestens sechs der elf Jahre muss Loomis in der „Jackson Correctional Institution“ absitzen, einer Haftanstalt mittlerer Sicherheitsstufe, die rund 70 Kilometer von La Crosse entfernt ist. Fünf Jahre lang unterliegt Loomis zudem einer „erweiterten Überwachung“, er muss also dauerhaft eine elektronische Fußfessel tragen, sollte er im Jahr 2019 aus dem Gefängnis entlassen werden.

Risikoeinstufung

Die selbst für amerikanische Verhältnisse drakonische Strafe hat Loomis vor allem einem Umstand zu verdanken: Der Software COMPAS, die inzwischen in mehreren US-Bundesstaaten zum Einsatz kommt und 2012 auch vom Department of Corrections (DOC) in Wisconsin eingeführt wurde. COMPAS steht für „Correctional Offender Management Profiling for Alternative Sanctions“ und gibt vor, das Rückfallrisiko von Straftätern verlässlich berechnen zu können.

Der Hersteller der Software, das auf IT-Dienstleistungen spezialisierte Unternehmen Northpointe Inc. mit Sitz in Michigan, vermarktet das COMPAS-Programm als „datengestütztes, statistisches Risikobeurteilungstool, das auf Basis einer ‚nationalen Normbevölkerung‘ validiert wurde“. Für jeden Delinquenten wird bei COMPAS ein individueller „Risk Score“ errechnet, der Auswirkungen auf das spätere Strafmaß hat.

In die Risikobeurteilung fließen nicht nur eigene Vorstrafen ein, sondern auch eventuelle Vorstrafen naher Verwandter wie Eltern und Geschwister. Berücksichtigt werden zudem Erkenntnisse über Alkohol- oder Drogenmissbrauch in der Familie, soziale Bindungen, der Umgang mit „anti-sozialen“ Freunden oder Bekannten, Schulden, häufige Wohnort- oder Beschäftigungswechsel, Tendenzen zu Wut oder Aggression sowie eine „kognitive Verhaltensprognose“.

Erfasst werden die einzelnen Parameter zum Teil über automatisierte Datenbankabfragen, zum Teil über Erhebungen, die Justizangestellte im Rahmen einer „Pre-Sentence Investigation“ (PSI) während der Untersuchungshaft durchführen. Herstellerangaben zufolge vergleicht die Software auf Grundlage dieser Daten dann, wie sich wegen vergleichbarer Delikte bereits Verurteilte mit einem ähnlichen sozialen Hintergrund zwei Jahre nach der Haftentlassung verhalten haben.

Die Logik hinter COMPAS ist recht simpel: Spuckt die Software für einen Angeklagten auf einer Skala von 1 bis 10 einen hohen Risk Score aus, lässt der Richter keine Bewährung zu, sondern schickt ihn präventiv hinter Gitter – schließlich belegen die Algorithmen ja, dass der zu Verurteilende mit hoher Wahrscheinlichkeit innerhalb von 24 Monaten sowieso wieder straffällig würde.

Schwarzer Kasten

Im Fall von Eric Loomis, der weiß Gott kein Chorknabe ist, dem im Strafverfahren aber auch keine Handlungen nachgewiesen werden konnten, die langjährige Haftstrafen gerechtfertigt hätten, ermittelte COMPAS nicht nur ein hohes Rückfallrisiko, sondern auch eine hohe Gewaltbereitschaft des Angeklagten. Für den Richter das Signal, Loomis gleich für mehrere Jahre aus dem Verkehr zu ziehen.

Allerdings legt Northpointe seine Algorithmen nicht offen, sondern beruft sich bei Nachfragen auf den Schutz geistigen Eigentums. Prozessbeteiligte können also nicht überprüfen, ob beim Berechnen eines Risk Scores womöglich Fehler passiert sind. Eric Loomis sah dadurch sein Recht auf einen fairen Prozess verletzt und strengte ein Berufungsverfahren an. Doch bislang haben alle Instanzen bis hinauf zum United States Supreme Court – das höchste Gericht der USA – seine Klagen abgewiesen.

Dabei steht inzwischen fest, dass COMPAS alles andere als zuverlässig ist. So belegt eine 2016 veröffentlichte Studie der Investigativ-Plattform ProPublica, dass die COMPAS-Algorithmen beispielsweise schwarzen Angeklagten grundsätzlich ein höheres Risiko attestieren, erneut straffällig zu werden, als dies tatsächlich der Fall ist. Bei weißen Angeklagten ist es hingegen genau umgekehrt. ProPublica überprüfte dazu mehr als 10.000 COMPAS-Prognosen, die im Verlauf von Gerichtsverfahren in Florida erstellt worden waren.

Maschinelles Lernen

Kritik am Einsatz der Northpointe-Software kommt auch aus der Wissenschaft. IT-Experten und Juristen renommierter US-Universitäten haben inzwischen eigene Machine-Learning-Algorithmen für Risikomodelle entwickelt, mit denen sich die Rückfallwahrscheinlichkeit von Straftätern mindestens genauso gut berechnen lassen soll wie mit COMPAS. Mit einem wichtigen Unterschied: Sowohl Richter als auch Angeklagte könnten jederzeit überprüfen, wie der Algorithmus zur Entscheidung kommt, jemand sei ein Hochrisiko-Fall oder nicht.

„In der Strafjustiz steht viel zu viel auf dem Spiel, als dass man blind einem proprietären Algorithmus vertrauen sollte“, erklärt Cynthia Rudin, IT-Dozentin an der Duke University. „Wir haben inzwischen Vorhersagemodelle, die gut funktionieren, die aber keine geheimen Black Boxes sind. Das dürfen wir im Interesse unserer Bürger nicht länger ignorieren.“

Rudin verweist in diesem Zusammenhang gerne auf Europa, wo 2018 eine neue EU-Datenschutz-Grundverordnung in Kraft tritt. Verankert ist darin unter anderem ein Passus, wonach Betreiber von Datenverarbeitungssystemen mit automatisierter Entscheidungsfindung künftig verpflichtet sind, betroffenen Personen „aussagekräftige Informationen über die involvierte Logik sowie die Tragweite und die angestrebten Auswirkungen einer derartigen Verarbeitung“ zur Verfügung zu stellen.

Voraussagende Polizeiarbeit

Algorithmen zur automatisierten Entscheidungsfindung sind auch die Basis sogenannter Predictive-Policing-Produkte, die häufig als eine Art Wundermittel für Polizeibehörden angepriesen werden. Beim Predictive Policing, also der „voraussagenden Polizeiarbeit“, unterscheidet man zwei Spielarten: Eine, die auf Individuen abzielt, bei der also intensiv personenbezogene Daten verarbeitet werden, wie das vor allem in den USA und Großbritannien bereits der Fall ist. Und eine, die weitgehend ohne personenbezogene Daten auskommt.

Personenbezogenes Predictive Policing bedeutet, dass Strafverfolgungsbehörden gezielt Informationen über Einzelpersonen oder auch Gruppierungen wie Gangs sammeln. Gearbeitet wird auch hier in der Regel mit Risk Scores: Wer eine bestimmte Schwelle überschreitet, bekommt präventiven Besuch von der Polizei. Welche Konsequenzen das für Betroffene haben kann, zeigt auf verstörende Weise der Dokumentarfilm „Pre-Crime“, der gerade in deutschen Kinos anläuft.

„Eines der größten Probleme ist, dass niemand die Daten kontrolliert, mit denen etwa in London oder Chicago beim personenbezogenen Predictive Policing gearbeitet wird“, warnt Regisseur Matthias Heeder. „Keiner weiß, wie diese Daten zustande kommen, aus denen die Algorithmen dann ihre Prognosen errechnen. Und ist man erst einmal in solch eine Maschinerie hineingeraten, existiert auch kein gesetzliches Verfahren, das einem helfen könnte, da wieder rauszukommen.“

Folgedelikte

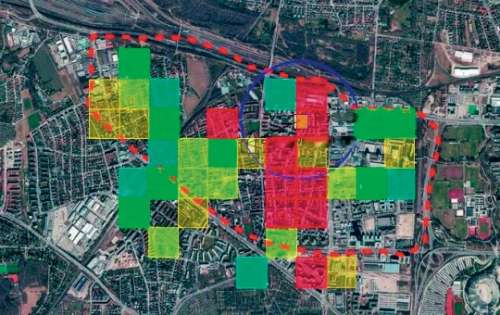

In Deutschland müssen sich die Polizeibehörden aus Datenschutzgründen derzeit noch auf nicht personenbezogene Predictive-Policing-Produkte wie „PRECOBS“ (Pre Crime Observation System) oder „PreMAP“ (Predictive Mobile Analytics for Police) beschränken. Bei beiden Programmen geht es darum, auf Grundlage von Falldaten der jüngsten Vergangenheit Prognosen darüber anzustellen, wo aktuell ein erhöhtes Risiko etwa für Wohnungseinbrüche oder Autodiebstähle besteht.

Theoretische Grundlage ist in beiden Fällen das sogenannte „Near Repeat Victimization“-Phänomen. Dieses besagt, dass insbesondere nach Delikten wie Einbruch, Straßenraub, bewaffnetem Überfall und Diebstahl aus einem Kraftfahrzeug oft in kurzer Zeit und im direkten Umfeld mit Folgedelikten zu rechnen ist. Ein automatisiertes Berichts- und Prognosesystem speist die auf Mustererkennung basierenden Erkenntnisse in die tägliche Einsatzplanung der Polizei ein.

Während Hersteller, Polizei und Innenpolitiker immer wieder argumentieren, durch den Einsatz solcher Software ließen sich „deutliche Tatreduktionen“ feststellen, kommt das Freiburger „Max-Planck-Institut für ausländisches und internationales Strafrecht“ in der 2017 erschienenen Studie „Predictive Policing als Instrument zur Prävention von Wohnungseinbruchdiebstahl“ zu einem ganz anderen Schluss.

Sechs Monate lang untersuchten die Freiburger Forscher die Wirksamkeit von PRECOBS im Rahmen eines Pilotprojekts im Verantwortungsbereich der Polizeipräsidien Karlsruhe und Stuttgart. Als Ergebnis schreiben die Verfasser, die „kriminalitätsmindernden Effekte“ von Predictive Policing lägen im Pilotprojekt „wahrscheinlich nur in einem moderaten Bereich“. Auch könnten die Fallzahlen „allein durch dieses Instrument nicht deutlich reduziert werden“, heißt es in der Studie.

Totalüberwachung

Wohin die Reise in Sachen Big-Data-Analysen, Mustererkennung, automatisierter Entscheidungsfindung, Risk Scores und Predictive Policing führt, zeigt das Beispiel China. Denn dort sollen bis zum Jahr 2020 sämtliche privaten und staatlichen Datenbanken miteinander verknüpft werden. Das Ziel: die Einführung eines landesweiten Scoring-Systems, dem alle Bürger unterworfen sind.

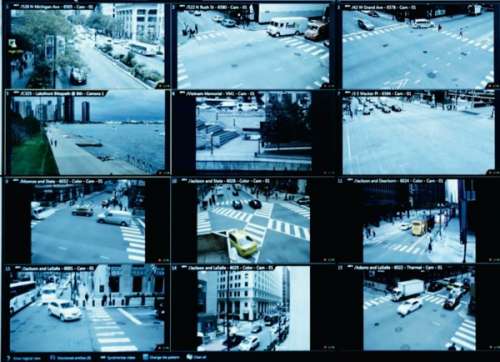

Erfasst werden soll jegliches Verhalten der Menschen – wer bei Rot über die Straße geht, erhält Minuspunkte, wer zu viele Minuspunkte einsammelt, wird gesellschaftlich geächtet. Ein flächendeckendes Videoüberwachungssystem mit angeschlossener zentraler Gesichtserkennungsdatenbank sorgt dafür, dass dem Staat nichts mehr entgeht. Belohnt wird nur, wer sich den Prinzipien des Staates kritiklos unterordnet. Einst fiktive Werke wie Minority Report, 1984 und „Person of Interest“ sind so aktuell wie niemals zuvor. (pmz@ct.de)