Datenmassen entrauscht

Wie Radioastronomen das Bild eines Schwarzen Lochs aus Petabytes an Daten berechnen

Riesige Radioteleskope, die Signale der Galaxie M87 belauschen, fangen vor allem Rauschen ein. Clevere Speicher- und Rechentechnik enthüllt das darin verborgene Bild des Ereignishorizonts eines Schwarzen Lochs und soll noch weitere Rätsel lösen.

Ein Backup? „Können wir uns nicht leisten“, erklärt Dr. Helge Rottmann vom Max-Planck-Institut für Radioastronomie (MPIfR) in Bonn. „Falls uns ein katastrophaler Datenverlust trifft, müssen wir eben die Messung wiederholen.“ Das wäre zwar ärgerlich, aber machbar: Denn die Galaxie Messier 87, den der Forschungsverbund Event Horizon Telescope (EHT) untersucht, strahlt nun schon seit 55 Millionen Jahren.

Der Backup-Verzicht hat wirtschaftliche Gründe: Die Astronomen stecken ihre knappen Geldmittel lieber in bessere Technik als in Redundanz. Der Erfolg gibt ihnen recht, denn im vergangenen April konnten sie das erste „Foto eines Schwarzen Lochs“ veröffentlichen. Mehr als 1 Milliarde Menschen dürften es gesehen haben, schätzt Professor Anton Zensus, Leiter des MPIfR und Vorstandsvorsitzender des EHT. Genau genommen zeigt das Bild die elektromagnetische Strahlung rund um den Ereignishorizont (Event Horizon), der das Schwarze Loch im Zentrum von Messier 87 (M87) umgibt. Wie der Name Schwarzes Loch andeutet, kann man es nicht direkt abbilden, weil keine Strahlung entweicht. Um das Loch herum bildet sich aber eine Zone, in der Materie von der extremen Anziehungskraft dermaßen stark beschleunigt wird und sich erhitzt, dass sie Radio- und Lichtwellen abstrahlt: die Akkretionsscheibe.

Wegen der gigantischen Entfernung von 55 Millionen Lichtjahren zwischen M87 und der Erde kommt die Strahlungsenergie nur extrem schwach bei den Radioteleskopen an. Die riesigen Antennen fangen deshalb bloß noch Signale ein, die von Rauschen kaum zu unterscheiden sind. Um daraus ein Bild zu destillieren, brauchen die Astronomen außer ihrem Wissen auch pragmatischen Experimentiergeist, viel Rechenleistung und massenhaft Speicherplatz.

Virtuelle Antennen

Die Signale, die ein einzelnes Radioteleskop von einem Objekt aus dem Weltall empfängt, liefern noch keine Informationen zu dessen Ausdehnung. Diese gewinnt man jedoch, wenn man die Signale von zwei oder mehr räumlich voneinander entfernten Teleskopen überlagert – man spricht von Radiointerferometrie. Früher wurden diese Signale analog „korreliert“, aber das klappt nur über begrenzte Distanzen. Speichert man jedoch digitalisierte Radiosignale mit hochpräzisen Zeitstempeln, die heutzutage von GPS-Satelliten kommen, lassen sich Signale von weit voneinander entfernten Teleskopen nachträglich per Software kombinieren. Bei der Very Long Baseline Interferometry (VLBI) steigt das Auflösungsvermögen mit der Entfernung der einzelnen Antennen voneinander. Die Messungen, aus denen das berühmte Bild entstand, stammen von Antennen an acht über den Globus verteilten Standorten.

Um die Auflösung weiter zu steigern, wertet das EHT Signale mit kurzer Wellenlänge von 1,3 Millimetern aus; sie liegen im Bereich um 230 Gigahertz (GHz). Zum Vergleich: WLAN arbeitet mit 2,4 und 5 GHz, Satellitenfernsehen zwischen rund 11 und 13 GHz. Das EHT hat eine Winkelauflösung von 20 Mikro-Bogensekunden; wäre es ein optisches System, könnte man damit von Berlin aus eine Zeitung in New York lesen.

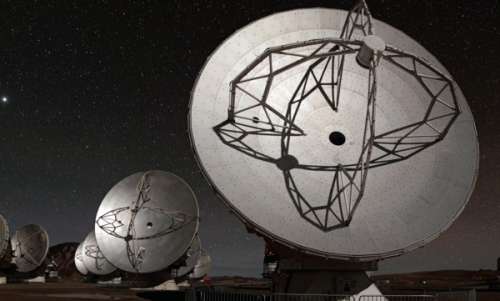

Elektromagnetische Wellen mit 230 GHz dämpft die Erdatmosphäre jedoch sehr stark, erst recht wenn Wolken aufziehen. Daher nutzt das EHT Antennen auf hohen Bergen in möglichst trockenen Gegenden und in Polarregionen: Der 30-Meter-Spiegel des IRAM steht beim Pico Veleta in Spanien auf 2850 Metern Höhe, die 66 Antennen des Atacama Large Millimeter/Sub-Millimeter Array (ALMA) in der chilenischen Wüste auf 5030 Metern. Der Name des South Pole Telescope (SPT) spricht für sich.

Während der Messung müssen alle Antennen gleichzeitig Sicht auf das Objekt am Himmel haben; das war im April 2017 während jeweils rund 5 Stunden täglich der Fall. Um die Erdrotation auszugleichen, folgen die schwenkbaren Antennen ihrem Ziel am Himmel. Die Oberfläche der riesigen Reflektoren muss auf Millimeterbruchteile genau glatt sein, um die kurzen Wellen optimal auf den Empfänger zu fokussieren.

2-Bit-Digitalisierung

Die hochempfindlichen Empfänger in den Frontends arbeiten mit Helium-Kühlung bei 15 Kelvin, um das Rauschen zu minimieren. Mehrere 2-GHz-Frequenzbänder aus dem Bereich um 230 GHz werden dann ins Basisband heruntergemischt, also jeweils in den Bereich von 0 bis 2 GHz.

An Standorten mit mehren Antennen wie ALMA arbeiten die verfahrbaren Einzelantennen als Phased Array zusammen: Durch durchdachte Positionierung und phasenversetze Kombination ihrer Signale funktionieren sie wie eine einzige, viel größere Antenne. Wasserstoff-Maser – eine Art Mikrowellen-Laser – dienen als hochpräzise lokale Taktgeber, um die Phasenlage der Signale zu erhalten.

Die Verstärkung, Filterung und Digitalisierung der Basisband-Signale übernehmen sogenannte Backends, die das MPIfR in Bonn auch selbst fertigt. Teile der Empfängertechnik wurden im Rahmen der langjährigen Forschungskooperation für das EHT von radioastronomischen Instituten in aller Welt erst entwickelt, darunter das ROACH2 Digital Backend RDBE2. Darin arbeiten rekonfigurierbare Prozessoren (Field Programmable Gate Array/FPGA) von Xilinx. Sie digitalisieren die Signale zunächst mit 8 Bit Auflösung und rechnen sie dann auf lediglich 2 Bit herunter – also auf nur vier verschiedene Werte. Das spart enorm viel Speicherplatz und somit Kosten, weil die Datenmassen schrumpfen. Trotzdem bleibt der wesentliche Teil der Informationen erhalten.

Pro Kanal mit 2 GHz Bandbreite entsteht ein Datenstrom mit 16 Gigabit pro Sekunde (GBit/s), also mit rund 7 Terabyte pro Stunde. Im April 2017 zeichneten die Astronomen an jedem der acht Antennenstandorte zwei 2-GHz-Bänder auf (32 GBit/s). Während der 36 Stunden Messdauer in fünf Nächten kamen zirka 450 TByte pro Antenne zusammen, also insgesamt rund 3,5 Petabyte.

Digitaler Höhenkoller

Bei der Hardware setzen die mehr als 60 am EHT beteiligten Institute aus aller Welt möglichst auf Standardprodukte, die billig, robust und überall erhältlich sind. Doch die Hardware muss unter extremen Bedingungen funktionieren: In 5000 Metern Höhe ist die Luft dermaßen dünn, dass die Kühlung zum Problem wird. Gängige Server sind beispielsweise für den Betrieb in maximal 3000 Metern ausgelegt. Auch die extrem trockene Luft führt laut Helge Rottmann vom MPIfR immer wieder zu Ausfällen elektronischer Bauelemente.

Vor allem kämpften die Astronomen jahrelang mit defekten Festplatten: Deren Schreibleseköpfe schweben dank Bernoulli-Effekt wenige Mikrometer über der Oberfläche der Magnetscheiben. Für 5000 Meter Betriebshöhe sind sie nicht ausgelegt. Die Lösung brachten die heute gängigen Festplatten mit Heliumfüllung, die hermetisch dicht sind. Von den rund 1000 Platten, die während der Messung 2017 gleichzeitig liefen, fiel keine einzige aus. Ein Ausfall weniger Platten wäre aber auch nicht tragisch, dann würde das Bild am Ende bloß ein bisschen weniger genau.

Die sogenannten „Mark 6“-Rekorder stehen in einer Ahnenreihe von immer weiter verbesserten Festplattenaufzeichnungssystemen für die Radioastronomie und können auch mit älteren Mark-5-Aufzeichnungen umgehen. Die Rekorder sind mit den Backends über 10-Gigabit/s-Ethernet (10GE) verbunden und müssen 16 GBit/s ohne Aussetzer „wegschreiben“. Im Prinzip handelt es sich um Linux-PCs mit x86-Prozessoren (Intel Core i), je zwei 10GE-Netzwerkkarten und SATA-kompatiblen SAS-Hostadaptern für 32 Festplatten. Je acht SATA-(Helium-)Platten mit derzeit 6 bis 10 TByte Kapazität sitzen in leicht wechselbaren Rahmen (Cartridges) und sind mit je zwei handelsüblichen MiniSAS-x4-Kabeln mit den SAS-Adaptern verbunden. Die Aufzeichnung der Datenströme samt Zeitstempeln erfolgt im standardisierten VLBI Data Interface Format (VDIF).

Schneckenpost

Vom Teleskop zum Rechenzentrum werden die Datenmassen physisch auf genau jenen Platten-Cartridges transportiert, auf denen sie aufgezeichnet wurden – siehe Aufmacherfoto. Denn an den Standorten der Teleskope gibt es kein schnelles Internet – und selbst wenn doch: Sogar eine 10GE-Verbindung schafft nur rund 1 GByte/s. Der Transfer von 450 TByte würde fünf Tage brauchen – da ist ein Flugzeug schneller.

Genau dieselben Mark-6-Rekorder wie an den Antennenstandorten stehen auch in den Computerräumen des MPIfR in Bonn und am MIT in Boston. Dort lesen Supercomputer-Cluster die Messdaten und werten sie aus. Jeweils die Hälfte der Berechnungen übernahmen MPIfR und MIT. Die Software DiFX korreliert jeweils die Messwerte von zwei Antennen; die gedachte Linie zwischen ihren Standorten nennt man Baseline – das „B“ in VLBI. DiFX steht für „Distributed FX“, wobei wiederum das F die Fouriertransformation und das X die Kreuzkorrelation andeuten. DiFX wird ständig weiterentwickelt und verwendet optimierte Software-Bibliotheken, um von den AVX-Einheiten moderner x86-Prozessoren zu profitieren. Der Flaschenhals bei der Korrelation ist allerdings nicht die Rechenleistung der Supercomputer, sondern die Transferrate der Festplatten. Als Faustregel schätzen die Astronomen, dass die Rechenzeit rund 3,5-mal so lange dauert wie die Messung; im Falle des berühmten EHT-Bilds waren es etwa fünf Tage.

Der Korrelator am MPIfR passt in vier Server-Racks und wurde von der Firma Megware gebaut. Jeder der 68 Cluster-Knoten hat zwei Intel-Xeon-Prozessoren mit je 10 Kernen, es stehen also 1360 Kerne bereit, die im Linpack-Benchmark rund 40 TFlops liefern würden. Die einzelnen Knoten sind untereinander, mit einigen Zugangs- und Steuerknoten sowie mit 15 lokalen (Supermicro-)Speichersystemen per Infiniband mit 56 GBit/s verknüpft. Die Speichersysteme stellen über 1 PByte Massenspeicher bereit, als Puffer für die VLBI-Daten und die Ergebnisse. Der Cluster schluckt im Betrieb zwischen 12 und 30 Kilowatt Strom.

Jet-Erkundung

Das MPIfR rechnet längst mit neuen Datensätzen, die 2018 auch mit zusätzlichen Teleskopen aufgezeichnet wurden. Letztlich wollen die Forscher genauer verstehen, wie der gigantische kosmische Jet entsteht, den M87 ausstößt. Dazu wird die Auflösung des EHT weiter verfeinert: Künftig will man Wellenlängen um 0,87 Millimeter messen, also bei 345 GHz, und mit 64 GBit/s aufzeichnen – auf noch mehr Festplatten, denn SSDs wären schlichtweg zu teuer. (ciw@ct.de)