Nvidia-Chef Huang: Wir wollen das nächste ChatGPT ermöglichen

Was der Nvidia-CEO damit meinte, warum es nicht nur auf die Rechenleistung ankommt und wie die Ankündigungen der GTC 2024 damit zusammenhängen – eine Analyse.

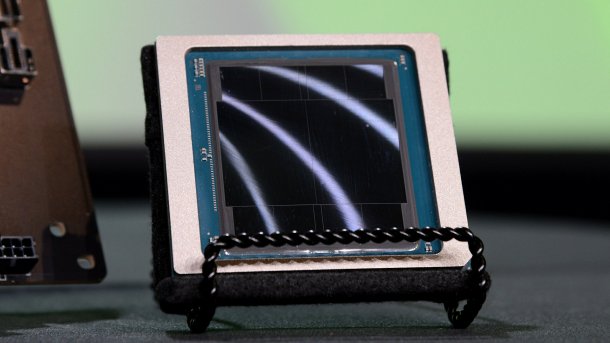

Nvidias B100 besteht aus zwei großen Chips, umrahmt von acht HBM3e-Stacks.

(Bild: c't / csp)

"Es ist unsere Aufgabe, das nächste ChatGPT zu ermöglichen", sagte Firmenchef Jen-Hsun Huang in einer Fragerunde mit Journalisten auf der Nvidia-Hausmesse GTC 2024. Er war gefragt worden, ob er einen Kommentar in einem Kurznachrichtendienst des KI-Startups Groq kommentieren könne, die nach der Vorstellung der neuen Nvidia-Blackwell-Chips lapidar schrieben, "still faster" – also ihre eigenen KI-Chips seien immer noch schneller als Nvidias angekündigter Beschleuniger.

Er kenne nicht alle Hintergründe dieser verkürzten Aussage, erläuterte Huang, um wirklich fundiert antworten zu können. KI sehe er aber nicht als das Problem eines Chips, sondern als ein Software-Problem an. Nvidias Aufgabe sei es, das nächste ChatGPT zu ermöglichen. Damit meinte er einen ähnlichen Durchbruch, wie es die Vorstellung des auf dem GPT-Modell basierenden Dienstes im Jahr 2022 für die KI gewesen sei. Er wäre überrascht, führte Huang weiter aus, wenn dies(er nächste Durchbruch) noch auf Llama-7B basierte. Damit spielte er auf das bekannte Large Language Model (LLM) Llama an, speziell in "kleineren" Varianten mit nur einigen Milliarden Parameter.

Die Anzahl der Parameter ist ein Maß für die relative Qualität innerhalb einer Modellfamilie und deuten gleichzeitig auch auf die benötigte, relative Speichergröße hin. Mit Parametern im niedrigen zweistelligen Milliardenbereich ist die zitierte Llama-Version eher auf der kleineren Seite.

Speicher ist König

Die Grundlage generativer KI sind sogenannte Large Language Models, die ihren Namen völlig zu Recht tragen. Aufgrund ihrer Größe benötigen sie Unmengen an Speicher und ihre Nutzung erfordert die unentwegte Kommunikation beteiligter Rechenwerke, seien die nun über einen Chip, über einen Serverschrank oder über ein ganzes Rechenzentrum verteilt.

Ian Buck, Nvidias Leiter Hyperscale & HPC erläuterte dazu noch einmal, dass bis zu 60 Prozent des Aufwandes auf diese Kommunikation entfielen, also Datentransfers, und nur 40 Prozent aus eigentlicher Rechenzeit bestünden.

Diesen Fokus merkt man Nvidias aktuellen Anstrengungen auch an. Ein großer Teil der Geschwindigkeitsgewinne der neuen Chips stammt von ihrer Transformer-Engine, die für einzelne Schritte die Datenmenge gegenüber der Vorgängergeneration halbieren kann. Dadurch lässt sich die nötige Genauigkeit und damit auch die notwendige Speichermenge in einem sogenannten Mixture-of-Experts-Prinzip optimieren.

(Bild: c't / csp)

Zusammen mit schnelleren Chip-zu-Chip-Verbindungen, schnelleren Netzwerkswitches sowie schnellerem und größerem Speicher treibt Nvidia daher immensen Aufwand, um die vorhandene und die in Form teuren Siliziums bezahlte Rechenleistung auch auf die Straße zu bringen.

Auf den Mix kommt es an

In diesem Zusammenhang erklärt sich dann auch der Sinn von Huangs Aussage. Nicht nur die Rechenleistung oder Speicherübertragungsrate auf dem Papier muss stimmen, sondern auch das Umfeld von der Netzwerktechnik bis hin zur Software.

Und gerade da hat Nvidia einem auf der GTC 2024 präsentierten Diagramm zufolge mit gemischten Genauigkeiten für einzelne Arbeitsschritte inzwischen große Fortschritte erzielt, die weit über die Geschwindigkeitssteigerung der einzelnen Chips im Vergleich zur Vorgängergeneration hinausgingen.

So erklärt sich auch ein Teil des von Nvidia ins Feld geführten Geschwindigkeitssprung von Faktor 30 eines Blackwell- gegenüber eines Hopper-Systems. Diesen Bestwerte erreichte man beim Training eines GPT-Modells mit 1,8 Billionen Parametern mit Mixture of Experts. Dabei stellte sich heraus, dass für verschiedene Kombinationen aus gewünschtem Durchsatz pro GPU (im Endeffekt also Kosten des Services) und Reaktionsfähigkeit auf User-Eingaben (also gefühlte Qualität des Dienstes) unterschiedliche Synchronisationsspannen von Tensoren, Pipeline, Experten und Daten zu den besten Resultaten führen. Für den Datenpunkt mit Faktor 30 gegenüber Hopper war das zum Beispiel TP2.EP16.PP2 – also Synchronisation der Tensoren über zwei GPUs, der Experten über 16 GPUs und der Pipelines über zwei GPUs.

(Bild: Nvidia)

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(csp)